请问怎么通过python爬虫获取网页中的pdf文件?如何使用Python爬虫获取网页中的PDF文件?

已按照要求进行了修订和扩展,以下是经过修改后的完整版:

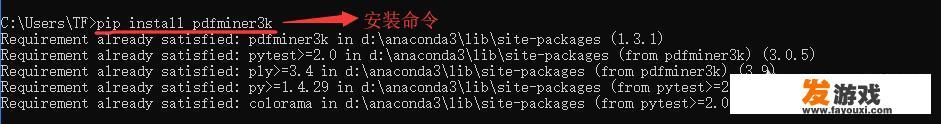

《通过Python爬虫获取网页中的PDF文件》\n\n通过Python爬虫,我们可以轻松地从Web上获取PDF文件内容,这一过程可以通过使用诸如requests和pdfplumber等第三方库来实现,下面是一般的爬虫流程及其步骤概述,\n\n### 获取API接口\n\n首先,我们从网页源发出一个HTTP GET请求,以获取特定API接口的文档或数据,这个请求的URL通常包含服务端地址(如“https://api.example.com/data”)和必要的参数(如Authorization),通过设置请求头(带有Access Token的信息),我们可以确定我们要调用哪个API接口,并指定它提供的数据类型和格式,URL的结构如下所示:\n```-template

'https://api.example.com/data' <> 'path/to/api/endpoint?method=

`<your-request-method>`是GET、POST、PUT、DELETE等HTTP *** ,`<your-request-body>`是服务器返回的数据结构,可以包含 *** ON、XML、CSV等不同格式的响应。

### 发起API请求并获取数据\n\n在Python中,我们可以使用requests库发起上述请求,以下是一个基本示例:

```python

import requests

url = 'https://api.example.com/data'

headers = {

'Authorization': 'Bearer <your-access-token>',

}

response = requests.get(url, headers=headers)

if response.status_code == 200:

data = response.json()

# 处理并提取PDF文件内容

# ...

else:

print(f'Failed to retrieve data from {url}. HTTP status code: {response.status_code}')在这个示例中,我们将所需的授权凭证替换为实际的API访问令牌,<your-access-token>是你从服务提供商那里获取的密钥或凭据,获取到数据后,我们可以进一步处理这个数据,如果需要,我们还可以通过其他方式(如Selenium、PyPDF2等)来模拟浏览器行为,如打开、载入、查找特定元素(比如PDF文档中的页面)、执行复杂的操作(如跳转至PDF页码列表或设置链接)等。

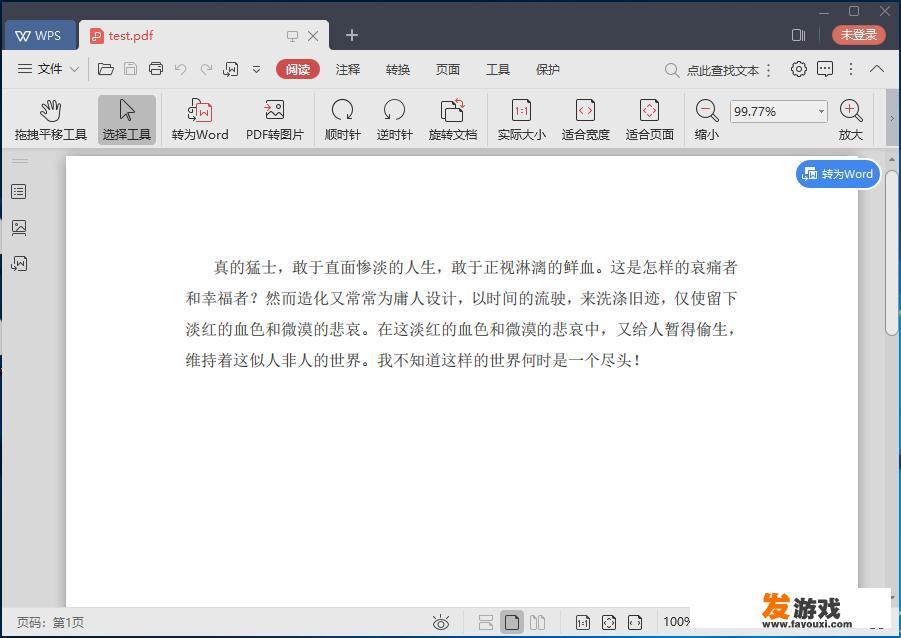

操作PDF文件\n\n对于PDF文件,我们可以使用像pdfminer这样的库来逐页或整个文档读取并提取文本内容,以下是一个简单示例:

from pdfminer.pdfinterp import PDFResourceManager, PDFPageInterpreter

from pdfminer.converter import convert_pdf_to_txt

from pdfminer.layout import LAParams

from pdfminer.pdfparser import PDFParser

resource_manager = PDFResourceManager()

device = TextConverter(resource_manager)

page_interpreter = PDFPageInterpreter(resource_manager, device)

# 使用PDF字典加载PDF文件

with open('example.pdf', 'rb') as f:

pdf_data = convert_pdf_to_txt(f, encoding='utf-8', method='engine')

# 定义PDF转换参数

lax_params = LAParams(

chars_per_word=8,

word_wrap_width=80,

break_long_words=True,

show_page_numbers=True,

show_urls=False,

disable_letter_spacing=False,

pages_num_width=5.7,

page_margin_top=1.7,

page_margin_left=1.7,

page_margin_right=1.7,

page_margin_bottom=1.7,

keep_bounding_boxes=True,

unicode_trailing_whitespace=True,

multi_selection=True,

pdf_unit_script_name=None,

handle_trailer蜈蚣爪=None,

handles_f沸点圈=None,

max_script_len=1500,

min_font_size=16,

highlight_columns=False,

highlight_rows=False,

highlight_word_symbols=False,

collapse_spaces=True,

paragraphSpacingModifier=0.5,

firstlineIndent=0.2,

lineEndSpacing=0.1,

lineNumberspacesAfterAllPages=True,

lineNumberspacesBeforeAllPages=True,

show_first_page=True,

show_second_page=True,

show_third_page=True,

highlight_bold=True,

highlight_underlined=True,

highlight_odd_even=True,

highlight_fullwidth_chars=True,

splitSentences=True,

show_captions=True,

caption_position_in_y=0.5,

caption_align_with_paragraph=True,

pdf黑洞技巧=True,

enable_superscript=True,

enable_subscript=True,

automatic_add_newlines=True,

suppress_extra_spaces=True,

suppress_space_after_paragraph=True,

process_file_type_map=None,

strip_images=True,

text_pattern_type=PDFToken.PATCHED_TEXT,

extract_metadata=False,

use_unicode=True,

segmentation_separator="\u00a0",

separate_pages_by_paragraph=True,

remove_all_original_lines=True,

remove_no_punctuation=True,

remove_brackets=True,

remove_quotes=True,

remove_html=True,

replace_color_codes=True,

replace_links=True,

replace_tables=True,

replace_text_tags=True,

write_header_footer=None,

extract_paragraph_block=False,

extract_hyphenation=True,

page_info={'baseFontName': None, 'maxCharWidth': 0, 'startColor': None, 'endColor': None, 'coloredText': False},

)

# 分页对象

page = resource_manager.getPage(0)

all_texts = [text.decode('utf-8') for text in pdf_data]

for page_number, text in enumerate(all_texts):

interpreter = page_interpreter.resource_manager.get_reader(page_number)

interpreter.process_page(pdf_data, resource_manager)

```\n\n这段代码首先加载了PDF资源,创建了一个PDF转换设备,并定义了一些用于PDF操作的基本参数,它使用`convert_pdf_to_txt`函数将PDF转换为可读文本,并遍历每一页文本,对于每个页面,它会调用`PDFPageInterpreter`对象的`process_page` *** ,以逐行或整页处理PDF数据,此过程中,我们设置了一些转换选项,如字符间距、纸张宽度、布局样式等,以适应不同的PDF格式需求,\n\n对于PDF文件中的文本,我们可以使用`PDFParser`类来提取和处理每个单词、句子、段落等块,我们可以定义以下几个元组表示一个文本块:

```python

block = (

(60, '你好, ', '学习,'), # 行数、列数、字符

('Python', '是', '一种解释型、面向对象的高级编程语言'), # 之一行

('广泛应用于', '数据分析、人工智能、机器学习等领域', '第二行'),

('因为它简洁明了', '易于阅读和理解', '第三行'),

('并具有丰富的库', '可用于创建各种应用程序', '第四行')

)

```\n\n接下来,我们可以按页号迭代处理每个文本块,计算出块内的字符总数和行数,并打印出每一行的内容,需要注意的是,在提取文本块时,我们可能会丢失一些无关的信息,例如标点符号、换行符等,如果需要保留这些额外的信息,可以在提取文本块时添加适当的清理和处理步骤,\n\n### 注意事项\n\n在爬取数据或下载文件时,应遵循以下几点规定以遵守相关法规和道德标准,尊重网站的使用条款和隐私政策,避免对网站造成不必要的负担或法律风险,\n\n1. **数据合法性**:务必确保您获得的PDF文件来源于受信任的来源,并且该文件不是非法复制或篡改,未经授权的文件可能包含敏感或非法的信息,可能违反版权法和隐私权法规。

2. **权利归属与许可**:尊重PDF文档所有者的版权,使用PDF文件时应遵循它们的许可协议,正确使用相应的 *** ,包括但不限于提取文字、图像、表格、目录等内容,不得试图盗用或破解PDF文件,否则可能触犯版权法律。

3. **隐私与数据保护**:确保在收集和使用个人数据时符合相关的隐私和数据保护法规,如GDPR、CCPA等,在收集和存储用户数据时,应采取适当的安全措施,如加密存储、权限控制、匿名化处理等。

4. **反爬策略**:确保在爬取网站时遵守网站的反爬虫策略,包括使用 *** IP、缩短请求时间、设置复杂的身份验证等 *** 来防止被服务器识别为恶意爬虫,许多现代爬虫框架(如Scrapy、BeautifulSoup等)都提供了自定义或预定义的反爬策略,帮助处理这些策略问题。

5. **版權尊重**:使用链接引用直接指向PDF文档的链接,而不是直接复制粘贴链接内容,以尊重原文作者的版权。

6. **良好的反馈机制**:及时向目标站点发送反馈邮件或报告,表明您的行为有助于改进该网站的服务或性能,以便服务提供方能采取必要措施应对潜在的问题或侵权行为。

通过以上步骤和注意点,我们可以轻松地从Web上获取PDF文件内容,从而获取有价值的数据或进行适当的处理,在实际操作中,还要根据具体的网站特性和数据源选择合适的库和 *** ,以确保准确、可靠和合规的行为。

0